[더구루=홍성일 기자] 구글과 스탠퍼드 대학교 연구자들이 2시간 인터뷰만으로 개인의 성격을 모방한 인공지능(AI) 모델을 개발했다. 이번 연구는 인간행동을 예측하는 데 큰 잠재력을 지니고 있다는 평가와 함께 윤리적 문제, 오용 가능성 등의 우려도 나오고 있다.

7일 업계에 따르면 박준성 스탠퍼드대학교 컴퓨터과학 박사 과정 학생이 대표 저자로 참여한 연구팀은 1000명의 생성 에이전트 시뮬레이션(Generative Agent Simulations of 1000 People)을 통해 인간의 성격을 모방한 '시뮬레이션 에이전트(simulation agents)'를 구축했다고 발표했다. 해당 논문은 지난해 11월 15일 논문 사전 공개 사이트 '아카이브(arXiv)'에 업로드됐으며 심사를 거치지는 않았다.

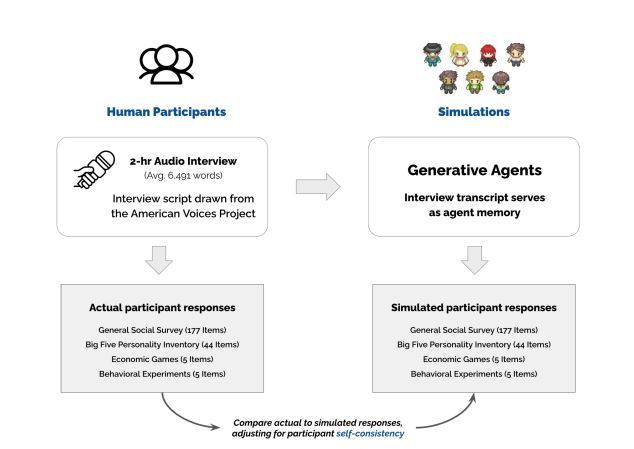

연구팀은 시뮬레이션 에이전트를 구축하기 위해 실험 참가자 1052명을 대상으로 2시간 인터뷰를 진행했다. 2시간 인터뷰를 통해 확보된 데이터는 인간 행동을 모방하도록 설계된 생성형 AI 모델을 훈련하는데 사용됐다. 실험 참가자들은 연령, 성별, 인종, 지역, 교육 수준, 정치적 이념 등 다양한 배경을 가진 사람들로 구성됐다.

1052명의 데이터로 만들어진 시뮬레이션 에이전트의 정확도를 확인하기 위해 연구팀은 2주에 걸쳐 2차례의 테스트를 실시했다. 참가자들은 성격 테스트, 사회적 설문 조사, 논리 게임 등을 진행했으며 시뮬레이션 에이전트는 참가자들의 응답 중 85%를 정확하게 모방하는데 성공했다. 단 연구팀은 시뮬레이션 에이전트 모델이 상호작용이 중요한 경제적 의사 결정 게임에서는 정확도가 떨어졌다고 설명했다.

연구팀은 시뮬레이션 에이전트가 통제된 환경에서 인간 행동을 예측하는데 도움이 될 것으로 기대했다. 특히 사회과학 등 인간 행동을 연구하는 부문에서 강점을 보일 것으로 전망했다. 구체적으로는 실제 인간을 피실험자로 동원했을 때 발생할 수 있는 비용, 윤리 문제들을 해결할 수 있을 것으로 봤다.

연구 결과가 공개되자 업계에서는 실제 인간으로 할 수 없는 연구를 수행할 수 있게 해줄 것이라며 디지털 트윈 기술 발전에 크게 기여할 것이라는 반응이 나왔다. 하지만 AI 클론을 만드는 기술인 만큼 오용 가능성, 개인 정보 보호 문제, 사회적 신뢰 훼손 등 윤리적 문제에 대한 우려도 제기되고 있다.

업계관계자는 "시뮬레이션 에이전트 정확도 테스트에 사용된 평가 방법은 비교적 초보적인 수준이었다. 그렇기 때문에 인간 성격과 행동의 복잡한 층위를 완전히 포착하지는 못했다"며 "딥페이크 등이 문제가 되고 있는 가운데 고도로 개인화된 AI클론의 등장은 우려를 불러일으킬 수 있다"고 말했다.